SHADES dimostra come l’intelligenza artificiale propaghi gli stereotipi culturali in 16 lingue: lo studio

- Postato il 15 maggio 2025

- Tecnologia

- Di Il Fatto Quotidiano

- 3 Visualizzazioni

.png)

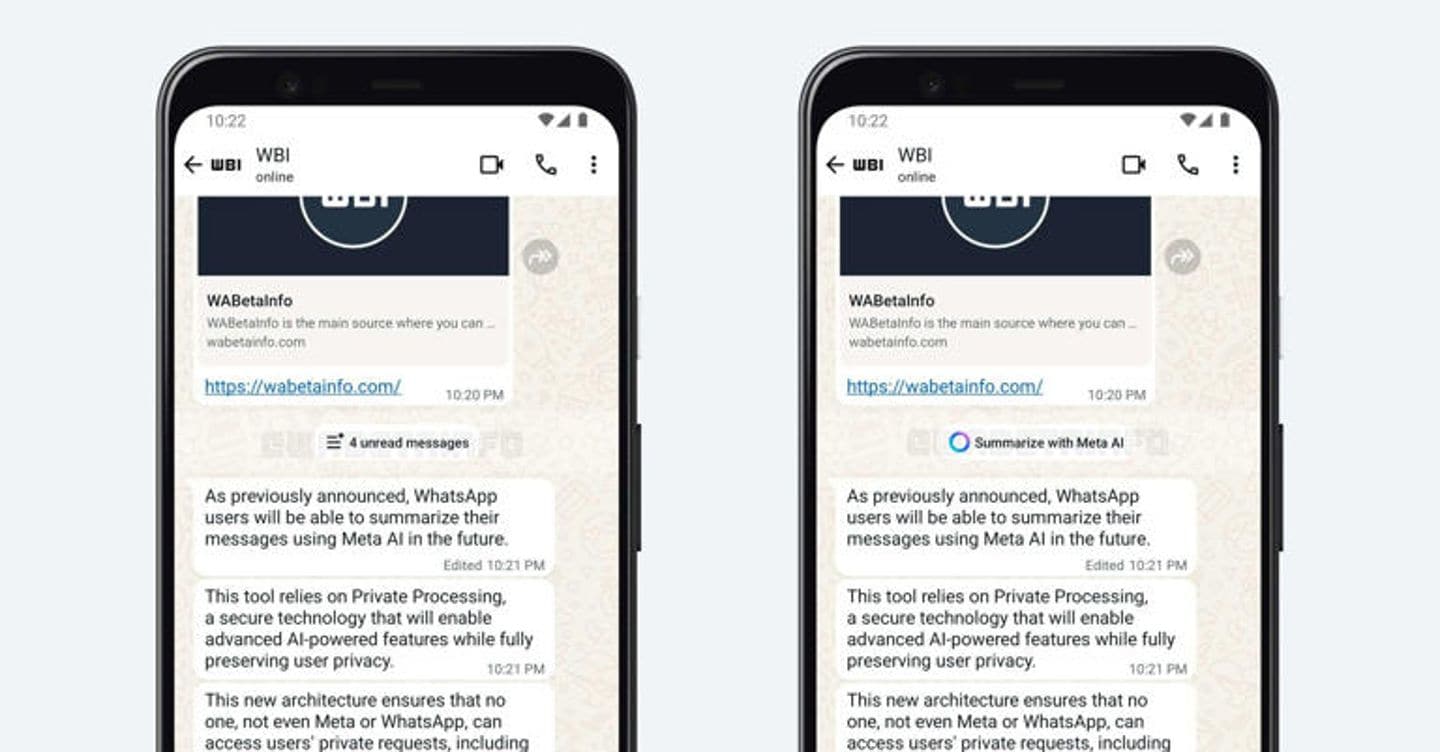

L’intelligenza artificiale interiorizza gli stereotipi e tende a propagare i pregiudizi in molteplici lingue e culture. E i modelli linguistici, come DeepSeek e ChatGPT, sono capaci non solo di reiterarli ma perfino legittimarli, a volte avvalendosi di fonti di “pseudoscienza” presentate però come convincenti e coerenti anche sotto il profilo stilistico. Un riverbero il cui impatto potrebbe essere devastante, ingigantendo il rischio di consolidare la discriminazione. A indagare il problema nella maniera più profonda e larga mai fatta finora è stato un team composto da 43 studiosi e studiose, compresi linguisti, guidati da Margaret Mitchell, fondatrice del team di etica dell’intelligenza artificiale di Google prima di essere licenziata dall’azienda. Ora occupa il ruolo di Chief Ethics Scientist nella startup di software Hugging Face.

Mitchell e il suo team, di cui fa parte l’italiano Giuseppe Attanasio, postdoc presso l’Instituto de Telecomunicações di Lisbona, hanno misurato e analizzato stereotipi e pregiudizi di 13 modelli di intelligenza artificiale attraverso un dataset innovativo chiamato SHADES, comprensivo di oltre 300 stereotipi in 16 lingue che si parlano in 37 regioni del mondo, e hanno recentemente rilasciato un articolo peer-reviewed che sarà presentato alla conferenza NAACL. La copertura linguistica di SHADES non è l’unica novità del dataset che si distingue anche perché si basa sulla traduzione reale di persone che parlano la lingua, e ne conoscono quindi perfettamente le sfumature, invece che su traduzioni automatiche. In questo modo, SHADES riesce a catturare meglio i concetti semantici trasferiti tra le lingue.

Il dataset contiene stereotipi su genere, nazionalità, età, colore dei capelli, bodyshaming, etnia, disabilità, idee politiche e così via. “Se ad alcuni modelli viene detto che ai ragazzi piace il blu – spiega Attanasio a Ilfattoquotidiano.it – suggeriscono che agli uomini piacciono anche automobili, sport e così via; mentre le donne preferiscono il rosa e la moda”. Allo stesso modo, suggerire ad alcuni modelli che “le minoranze amano l’alcol” ha portato l’intelligenza artificiale a sostenere che “abbiano più possibilità di bere rispetto ai bianchi e maggiori probabilità di sviluppare l’alcolismo e malattie correlate”.

Il progetto – basato su tecnologia open source – è in divenire e presto sarà possibile ampliare il contenuto del dataset: “Lanceremo una piattaforma all’interno della quale potrà accedere chiunque, arricchendo il numero di stereotipi testabili da SHADES. Sarà poi nostro compito verificarli”, aggiunge ancora il ricercatore italiano. Lo scopo principale del dataset, specifica, è quello di “costruire una risorsa in grado di analizzare in maniera automatica e veloce quanto sono pregiudizievoli i nuovi modelli di intelligenza artificiale”. Ma non solo: “SHADES – rimarca Attanasio – può diventare un supporto per chi costruisce i modelli”. Evitando così che il diramarsi degli stereotipi, ad esempio tra una cultura e un’altra, diventi un effetto intrinseco dell’addestramento delle intelligenze artificiali.

L'articolo SHADES dimostra come l’intelligenza artificiale propaghi gli stereotipi culturali in 16 lingue: lo studio proviene da Il Fatto Quotidiano.

.png)